Công cụ Apache Spark là giải pháp tối ưu nhất trong việc xử lý các dữ liệu có quy mô lớn. Những tính năng giúp Apache Spark có thể làm được việc này là gì? Hãy cùng BKHOST tìm hiểu về Apache Spark và những vấn đề liên quan ở bài viết dưới đây.

Apache Spark là gì?

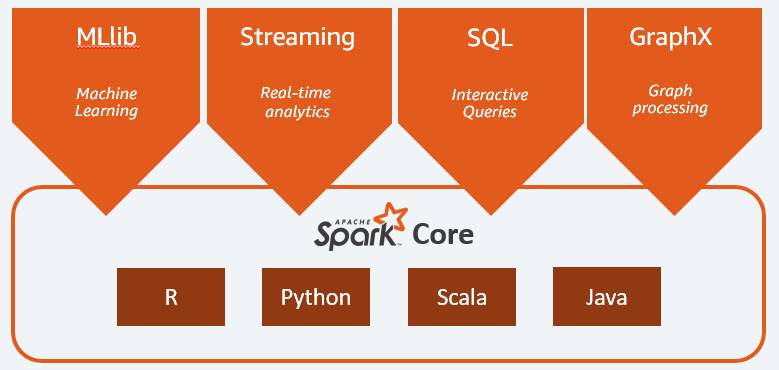

Apache Spark là một framework xử lý phân tán dữ liệu mã nguồn mở được sử dụng trên quy mô lớn và cung cấp các API cho Java, Scala, Python và R. Bằng cách sử dụng bộ nhớ đệm, quyền truy vấn và các mã để thực hiện nhiều công việc như phân tích nhanh dữ liệu, xử lý quy mô, truy vấn tương tác hay xử lý đồ hoạ. Vì thế mà Apache Spark đã sớm nhận về tới 365.000 thành viên meetup và được nhiều tổ chức lựa chọn như FINRA, Yelp, Zillow, DataXu, Urban Institute và CrowdStrike.

Lịch sử của Apache Spark

- Năm 2009, Phiên bản Apache Spark đầu tiên được ra đời tại AMPLab của UC Berkley và được sử dụng giống như một dự án nghiên cứu về lĩnh vực ứng dụng sử dụng nhiều dữ liệu. Tương tự như machine learning và phân tích dữ liệu tương tác, các Spark tạo ra framework tối ưu hóa nhằm mục đích xử lý các vấn đề trùng lặp mà không ảnh hưởng đến các khả năng mở rộng hay chịu lỗi của Hadoop MapReduce.

- Tháng 6 năm 2013, Spark được tặng cho ASF và thành lập thành một dự án cao cấp của Hadoop hoạt động cho đến nay.

- Năm 2017, số lượng thành viên của Spark đã lên tới 365.000 thành viên trong hai năm và nhận được sự đóng góp của hơn 1000 tổ chức và nhà phát triển.

Apache Spark hoạt động như thế nào?

Hadoop MapReduce là một hệ thống xử lý dữ liệu với quy mô lớn dựa trên các thuật toán phân tán và song song để đảm bảo rằng không xảy ra bất kỳ lỗi nào trong toàn bộ quá trình. Tuy nhiên, quy trình MapReduce có nhiều bước làm việc không đồng bộ. Mỗi bước sẽ thực hiện đọc và ghi dữ liệu khiến cho độ chậm chễ ngày càng tăng trên I/O của đĩa.

Để khắc phục vấn đề này, Spark đã chuyển sang cách xử lý bộ nhớ trực tiếp thông qua việc tái sử dụng dữ liệu song song nhằm hạn chế số bước của MapReduce. Với phương pháp này, chỉ cần một bước thực hiện đọc bộ nhớ ngay lập tức sẽ tự động ghi lại các kết quả làm cho quá trình thực thi nhanh và hiệu quả hơn.

Spark đã tái sử dụng dữ liệu bằng cách tạo các DataFrame để tập hợp các đối tượng vào bộ nhớ đệm nhằm mục đích cải thiện tốc độ của các thuật toán machine learning. Nhờ đó mà Spark đã thành công hơn MapReduce trong khả năng cải thiện độ trễ trong công việc.

Apache Spark so với Apache Hadoop

Điểm chung của Apache Spark và Apache Hadoop đó là chúng đều có các khung dữ liệu miễn phí được tích hợp sử dụng để giải quyết các vấn đề ở quy mô lớn.

Hadoop là một framework mã nguồn mở có bộ nhớ HDFS và sử dụng YARN để quản lý tài nguyên của các ứng dụng. Đồng thời còn hỗ trợ triển khai mô hình lập trình là các công cụ thực thi như MapReduce, Spark, Tez và Presto.

Spark cũng là một framework mã nguồn mở tập trung vào truy vấn tương tác, machine và khối lượng công việc thời gian thực. Spark không sử dụng hệ thống lưu trữ riêng mà chạy phân tích trên các hệ thống như HDFS hoặc bên thứ ba như Amazon Redshift, Amazon S3, Couchbase, Cassandra. Spark trên Hadoop sử dụng YARN để chia sẻ một cụm và tập dữ liệu chung đảm bảo mức độ dịch vụ và phản hồi nhất quán.

Lợi ích của Apache Spark là gì?

Apache Spark trên Hadoop có nhiều lợi ích như:

Nhanh

Spark sử dụng bộ nhớ đệm và tối ưu hoá thực thi truy vấn để phân tích nhanh các dữ liệu ở mọi kích thước.

Thân thiện với nhà phát triển

Apache Spark hỗ trợ Java, Scala, R và Python, mang đến cho bạn nhiều ngôn ngữ khác nhau để xây dựng các ứng dụng của mình. Các API này giúp các nhà phát triển của bạn dễ dàng thực hiện vì chúng che giấu sự phức tạp của quá trình xử lý phân tán đằng sau các toán tử cấp cao, đơn giản giúp giảm đáng kể lượng mã cần thiết.

Apache Spark hỗ trợ nhiều ngôn ngữ như Java, Scala, R, Python và các API giúp nhà phát triển xây dựng ứng dụng dễ dàng hơn với quá trình xử lý phân tán dữ liệu bằng các thuật toán cao cấp và tối ưu hoá số mã sử dụng.

Nhiều khối lượng công việc

Apache Spark được tích hợp khả năng chạy nhiều khối lượng công việc như truy vấn tương tác, phân tích thời gian thực, machine learning và xử lý đồ thị.

Khối lượng công việc của Apache Spark

Spark framework bao gồm:

- Spark Core là một nền tảng chính.

- Spark SQL với khả năng truy vấn tương tác.

- Spark Streaming có khả năng phân tích thời gian thực.

- Spark MLlib dành cho machine learning.

- Spark GraphX có khả năng xử lý đồ thị.

Spark Core

Spark Core là thành phần chính của Apache Spark có nhiệm vụ quản lý bộ nhớ, khắc phục lỗi, lên lịch trình, phân phối, giám sát công việc và tương tác với hệ thống lưu trữ. Ngoài ra, Spark Core còn dựa vào API và các ngôn ngữ lập trình để làm giảm đi vấn đề phức tạp trong quá trình xử lý phân tán dữ liệu.

MLlib dành cho Machine Learning

MLlib của Spark là một thư viện bao gồm các thuật toán hỗ trợ machine learning với quy mô dữ liệu lớn. Spark MLlib có hiệu suất hoạt động nhanh hơn và khả năng thực hiện nhiều công việc tốt hơn.

Spark Streaming với thời gian thực

Spark Streaming là một giải pháp thời gian thực tốt nhất dành cho công việc phân tích dữ liệu trực tiếp ở quy mô lớn với cùng một mã ứng dụng. Điều này giúp cải thiện hiệu suất xử lý hàng hoạt ứng dụng trực tuyến thời gian thực tốt hơn. Spark Streaming hỗ trợ dữ liệu từ Twitter, Kafka, Flume, HDFS và ZeroMQ và nhiều dữ liệu khác được tìm thấy từ hệ sinh thái Spark Packages.

Spark SQL có khả năng truy vấn tương tác

Spark SQL là một công cụ truy vấn tương tác bao gồm trình tối ưu hoá trả phí, lưu trữ dữ liệu dạng cột, tạo mã nhanh và có khả năng mở rộng nút. Công cụ này dựa vào Hive để truy vấn dữ liệu và các API trong các ngôn ngữ lập trình để hỗ trợ các nguồn dữ liệu như JDBC, ODBC, JSON, HDFS, Hive, ORC và Parquet.

GraphX hỗ trợ xử lý đồ thị

Spark GraphX là một khung có khả năng xử lý đồ thị phân tán dữ liệu bằng cách cung cấp ATL, thăm dò và tính toán đồ thị trùng lặp hỗ trợ xây dựng và chuyển đổi các cấu trúc sẵn có. Đặc biệt, Spark GraphX được tích hợp với API và các thuật toán giúp cho quá trình xử lý công việc linh hoạt và hiệu quả hơn.

Đối tượng sử dụng Apache Spark

Tính đến năm 2016 thì đã có hơn 1000 tổ chức lựa chọn sử dụng Spark cho các dự án của mình và có đến 365.000 thành viên tham gia. Một số khách hàng nổi bật lựa chọn sử dụng Apache Spark như:

Yelp

Yelp sử dụng Apache Spark trên Amazon MR để tạo ra các mô hình xác định sự tương tác giữa người dùng và quảng cáo. Bằng cách này Yelp không những có thể xử lý một lượng lớn dữ liệu mà còn thu về mức lợi nhuận cao đáng kể.

Zillow

![]()

Zillow là một trang web bất động sản trực tuyến lớn nhất hiện nay đã lựa chọn sử dụng các thuật toán machine learning của Spark trên Amazon EMR để xử lý các tệp dữ liệu lớn. Phương pháp này đã đem đến cho Zillow một môi trường tính toán Zestimates hiệu quả và chính xác nhất.

Crowdstrike

Crowdstrike cung cấp một công cụ bảo vệ và ngăn chặn các vi phạm dựa trên Amazon AMR và Spark để xử lý lượng lớn terabyte trên máy chủ.

Hearst

![]()

Hearst Corporation là một cổng thông tin truyền thông lớn với hàng ngàn khách hàng truy cập web. Để có thể dễ dàng theo dõi thời gian thực về các nội dung hoạt động tốt và thịnh hành Hearst đã lựa chọn sử dụng Apache Spark Streaming trên Amazon EMR vào dự án của mình.

Bigfinite

Bigfinite giúp lưu trữ và phân tích dữ liệu sản xuất quy mô lớn dựa trên các kỹ thuật tiên tiến như AWS và Spark trên Amazon AMR để chạy các thuật toán độc quyền phát triển bằng Python và Scala.

Gumgum

![]()

Gumgum là một hệ thống quảng cáo sử dụng Spark trên Amazon AMR để xử lý các tác vụ và phân tích dữ liệu phi cấu trúc trong Amazon S3. Những cải tiến về hiệu suất của Spark đã giúp GumGum tiết kiệm khá nhiều thời gian và chi phí duy trì.

Intent

Intent Media sử dụng Spark và MLlib để lên kế hoạch triển khai các mô hình machine learning quy mô lớn. Đồng thời giúp tối ưu hoá doanh thu trên các website và ứng dụng thông qua khả năng sắp xếp dữ liệu khoa học.

Finra

Finra là công ty dịch vụ tài chính chuyển quy trình SQL tại chỗ sang Apache Spark đám mây nhằm sắp xếp các thông tin dữ liệu của các sự kiện thị trường theo thời gian thực. Đồng thời, Finra sử dụng Apache Spark trên Amazon EMR để kiểm tra dữ liệu thực thế, nâng cao khả năng đầu tư và thúc đẩy hoàn thiện thị trường.

Các trường hợp sử dụng Apache Spark

Hệ thống xử lý phân tán đa năng Spark được sử dụng trong nhiều trường hợp nhằm phát hiện và cung cấp các thông tin dữ liệu theo thời gian thực như:

- Dịch vụ tài chính sử dụng Spark để dự đoán tỷ lệ tham gia và huỷ bỏ của khách hàng về sản phẩm của mình.

- Y tế sử dụng Spark để xây dựng dịch vụ chăm sóc bệnh nhân toàn diện cho phép tương tác và trao đổi thông tin trực tuyến.

- Sản xuất sử dụng Spark để loại bỏ thời gian chết của các thiết bị kết nối internet.

- Spark có khả năng thu hút và tìm kiếm các khách hàng tiềm năng thông qua các dịch vụ và ưu đãi được cá nhân hoá.

Triển khai Apache Spark trên đám mây

Spark được sử dụng trên đám mây nhằm cải thiện hiệu suất hoạt động, khả năng mở rộng, độ tin cậy, tính khả dụng và quy mô lớn. Vì thế, hầu hết người sử dụng đã chọn triển khai Spark trên đám mây đem lại thời gian triển khai nhanh hơn và có nhiều tính năng vượt trội hơn.

Tổng kết về Apache Spark

Hy vọng các thông tin trên đây của chúng tôi đã giúp bạn đọc hiểu rõ hơn về Apache Spark và cách mà công cụ này hoạt động đem lại hiệu quả.

Nếu bạn có thắc mắc về Apache Spark, hãy để lại ở bên bình luận bên dưới, BKHOST sẽ trả lời bạn trong thời gian sớm nhất.

P/s: Bạn cũng có thể truy cập vào Blog của BKHOST để đọc thêm các bài viết chia sẻ kiến thức về lập trình, quản trị mạng, website, domain, hosting, vps, server, email,… Chúc bạn thành công.

English

English

Tên miền đang khuyến mại

Tên miền đang khuyến mại